6月19日-20日,在云計算領域行業年度盛事——亞馬遜云科技中國峰會(AWS Summit) 在上海世博中心盛大舉行。作為本屆峰會銀牌贊助商,Zenlayer 攜最新 AI 基礎設施解決方案亮相,通過專屬展臺全方位展示最新產品成果。

在6月20日“合作伙伴開放麥”環節中,Zenlayer 高級解決方案架構師郭天銘發表主題演講《AI 全球化調用與 Token 傳輸優化》,深度剖析當下企業 AI 部署痛點與破局之道。

AI 模型調用時代的三大挑戰:協同難、延遲高、開銷大

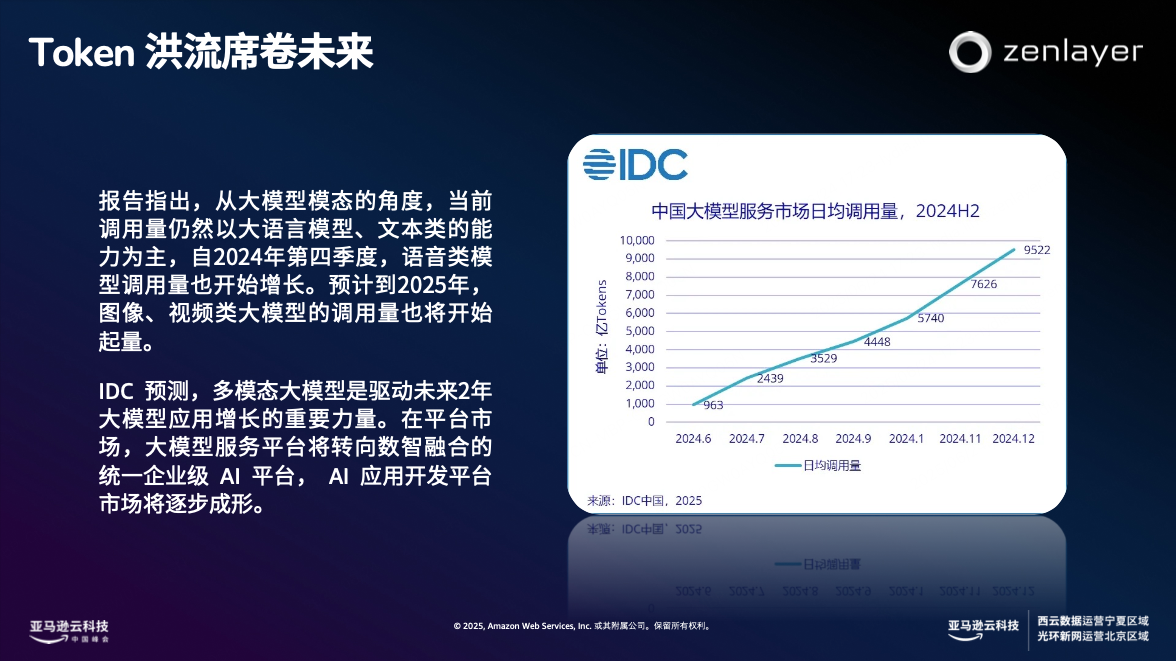

當前大模型的核心發展趨勢存在三個關鍵方向:多模態融合、多模型協同以及 RAG 架構普及。

IDC 預測,多模態大模型是驅動未來 2 年大模型應用增長的重要力量。在平臺市場,大模型服務平臺將轉向數智融合的統一企業級 AI 平臺,多模型協同逐漸成為 AI 應用主流場景。而為了降低 AI 幻覺、提升數據輸出的準確度,RAG 架構逐漸成為 AI 部署的標配。

在這一趨勢下,AI 的能力雖然得到提升,卻以復雜度、成本與延遲為代價,企業部署 AI 時挑戰重重:

1. 模型接入與管理困境

• 多模型接入復雜:不同模型的 API 接口、數據格式、調用方式各異,開發和集成的工作量成本巨大。

• Token 成本激增:據估算,一家中型企業每月調用大模型的 Token 數量可達千萬級,僅Token 調用曾本就可能高達數萬美元。

• 跨境延遲與卡頓:數據傳輸延遲嚴重,例如從中國調用美國的 OpenAI 模型,平均延遲高達 200ms 以上,網絡不穩定將進一步引發業務中斷風險。

• 系統集成與分散計費:需解決數據安全、權限管理等集成難題,且需對接多個服務商計費系統,管理負擔沉重。

2. RAG 場景的疊加挑戰

• 鏈路更長,延遲增加:RAG 架構的多跳通信顯著延長響應時間

• Token 消耗倍增:需要拼接大量上下文,Token 消耗通常是普通對話的 3-5 倍甚至更高

郭天銘指出,企業必須具備“就近處理 + 高質量傳輸 + 多模型協同”的能力,方能破解上述難題。

Zenlayer AI Gateway:讓 AI 模型調用更絲滑

針對行業痛點,Zenlayer 創新推 Zenlayer AI Gateway 解決方案,通過整合全球超連接網絡與 Zenlayer AI Gateway 平臺,為企業打造端到端的 AI 部署優化方案。該方案已助力某頭部社交平臺實現開發運維成本降低 20%。

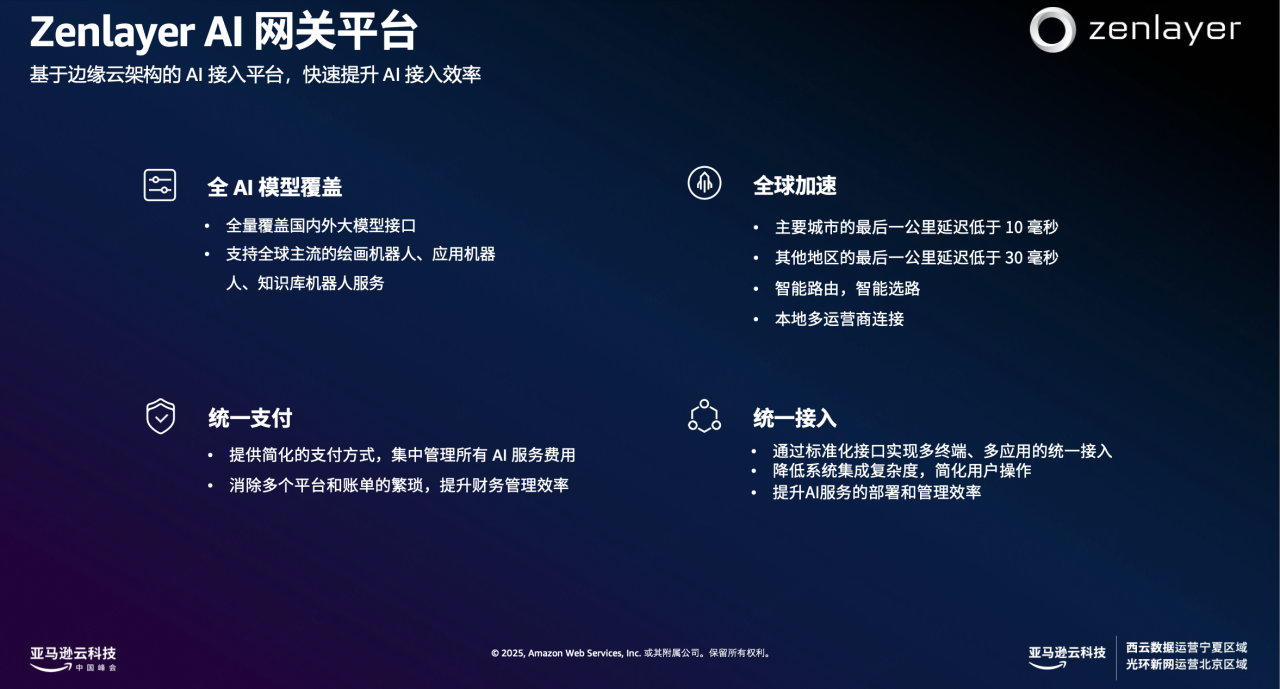

Zenlayer AI Gateway 是 Zenlayer 推出的新一代 AI 加速平臺,它通過統一接口大幅提升了 AI 模型調用效率。該產品具備四大核心功能:

1. 統一接入,無縫切換

集成全球主流 AI 模型(如OpenAI、Claude、Amazon Bedrock、國產模型、開源模型等),通過標準化接口統一接入

支持模型一鍵切換、混合調用(主備/災備),大幅降低多模型接入的開發和運維復雜度。

2. Token 傳輸優化

對重復請求進行語義緩存,減少重復 Token 消耗,尤其適用于 RAG、多模型混合調用等高 Token 場景。

3. 全球網絡加速

在多區域場景中(如法蘭克福、洛杉磯、新加坡),1M Token 請求經公網傳輸平均耗時約 3600 ms,而通過 ZGA 邊緣加速可優化至約 700ms 左右,實現 80% 的性能提升,顯著提升全球范圍內的 AI 響應速度與穩定性。

4. 企業級安全與部署靈活性

支持私有化部署,集成企業認證、權限控制及內容過濾,保障數據安全。

可加速調用 Amazon 云服務(Lambda/SageMaker/Bedrock),優化混合云 AI 應用體驗。

展望未來,面對多模型協同與 RAG 普及的大趨勢,Zenlayer 將依托自身廣泛的全球網絡優勢,不斷迭代 Zenlayer AI Gateway 產品,為企業提供更靈活、高效、經濟的 AI 模型全球化調用與 Token 優化解決方案。